این چهرهها واقعی نیستند

مجلهی معتبر تایمز در ماه مارس ۲۰۲۲ (اسفند ۱۴۰۰ و فروردین ۱۴۰۱) مطلبی دربارهی یک زن ۱۸ سالهی اوکراینی به نام لوبا دُوژنکو منتشر کرد تا زندگی ساکنان این کشور در شرایط بحرانی فعلی را شرح دهد. مقالهی تایمز ادعا میکرد که لوبا دوژنکو روزنامهنگاری خوانده است، زبان انگلیسی را بهخوبی صحبت نمیکند و پس از آغاز عملیات نظامی روسیه، تصمیم گرفته اسلحه به دست بگیرد.

آنطور که دیجیتال ترندز مینویسد، لوبا دوژنکو شخصیتی حقیقی نیست و مقالهی تایمز مدتزمان کوتاهی پس از انتشار، از روی سایت حذف شد. دوژنکو شخصیتی جعلی در فضای آنلاین بود که با تمرکز بر حواشی بین روسیه و اوکراین در توییتر جلب توجه کرد و توانست فالورهای زیادی جذب کند.

حساب کاربری متعلقبه دوژنکو تا قبل از ماه مارس ۲۰۲۲ هیچ توییتی منتشر نکرده بود. همچنین تا قبل از آن زمان، حساب یادشده نام کاربری متفاوتی داشت. بهعلاوه توییتهایی که حساب لوبا دوژنکو دربارهی وضعیت اوکراین منتشر میکرد، از روی توییتهای حسابهای کاربری افراد واقعی کپی شده بود. احتمالاً همین توییتها باعث شدند که نظر مجلهی تایمز به حساب لوبا دوژنکو جلب شود.

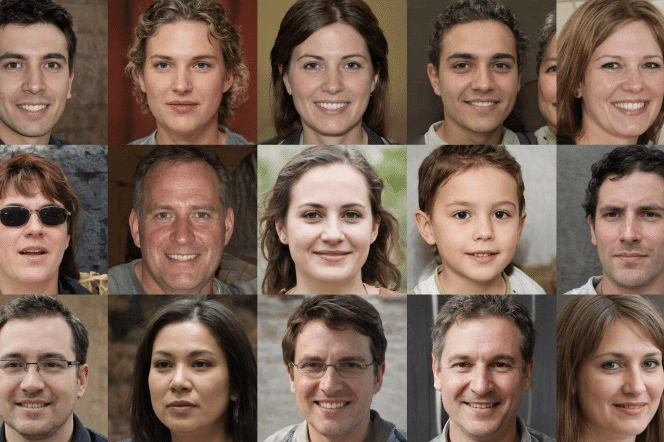

در ابتدا تقریباً همه فکر میکردند که دوژنکو شخصیتی واقعی است، اما بزرگترین مدرک برای اثبات جعلی بودن این شخصیت دقیقاً همانجا جلوی چشم همهی کاربران بود: تصویر پروفایل.

لوبا دوژنکو، کاربر جعلی توییتر

در بخشی از تصویر پروفایل لوبا دوژنکو با دقت میشد فهمید که بخشی از موهای او از سرش جدا است. همچنین بررسیها نشان میداد چند مژهی او در تصویر مشخص نیست و مهمتر از همه، چشمهایش بهشکلی غیرطبیعی در وسط قاب تصویر دیده میشدند.

تمامی این شواهد نشان میدادند با تصویری مواجه هستیم که توسط الگوریتم مبتنیبر هوش مصنوعی خلق شده است.

چهرهی لوبا دوژنکو توسط فناوریهایی که باعث بهوجودآمدن محتوای دیپ فیک شدهاند ساخته شده بود. دیپ فیک تکنیک جدیدی نیست، اما بهدلیل پیشرفت فناوری در سالهای اخیر بهشدت مورد توجه قرار گرفته است.

دیپ فیک به شما امکان میدهد تصویر چهرهی یک فرد را روی چهرهی فردی دیگر در داخل ویدئو قرار دهید. محتواهای دیپ فیک ممکن است بسیار خطرناک باشند؛ تحلیلگران بارها هشدار دادهاند که افراد سودجو میتوانند از دیپ فیک برای تولید سخنرانی غیرواقعی رهبران جهان استفاده کنند و مشکلاتی سیاسی به بار بیاورند. دیپ فیک همچنین بهدلیل پتانسیلی که برای تولید محتوای مستهجن دارد، تکنیکی نگرانکننده برای بازی با آبروی افراد است. مدتی قبل ویدیوهای دیپ فیک تام کروز، بازیگر معروف هالیوودی در شبکهی اجتماعی تیک تاک خبرساز شده بود.

The facial feature positioning isn't the only anomaly in @lubadovzhenko1's profile pic; not the detached hair in the lower right portion of the image and the partially missing eyelashes (among other things). pic.twitter.com/UPuvAQh4LZ

— Conspirador Norteño (@conspirator0) March 31, 2022

وقتی به الگوریتمهای مبتنیبر دیپ فیک صدها میلیون عکس از افراد واقعی تزریق کنید، این الگوریتمها دقیقتر میشوند و میتوانند تصاویری مثل آنچه در تصویر پروفایل لوبا دوژنکو دیدیم خلق کنند. محتواهای دیپ فیک بسیار مشکلسازند و مقابله با اطلاعات غلط را بسیار سختتر میکنند.

ارتشی از چهرههای غیرواقعی

در سالهای اخیر مقابلهی شبکههای اجتماعی با حسابهای کاربری غیرواقعی و ترول که معمولاً هیچ تصویر پروفایلی ندارند، شدیدتر شده است. در همین حین افراد سودجو که بهدنبال تولید محتواهای اسپم هستند بهلطف هوش مصنوعی به ابزار پرقدرت و ارزشمندی مجهز شدهاند. این افراد به کمک الگوریتمهای دیپ فیک تصاویری خلق میکنند که بهطرز هشداردهنده و ترسناکی واقعی به نظر میرسد.

قبلا ترولها تصویر افراد واقعی را روی حساب کاربری خود میگذاشتند و با انجام یکسری کارها میشد صاحب اصلی تصویر را پیدا و به جعلی بودن حساب کاربری پی برد، اما انجام این کار برای تصاویری که با هوش مصنوعی خلق شدهاند تقریباً غیرممکن است، چون این تصاویر تازه و منحصربهفرد هستند.

بسیاری از مردم حتی در صورتی که با دقت به تصویر نگاه کنند، متوجه غیر واقعی بودن آن نمیشوند. دلیل این است که هوش مصنوعی در سالهای اخیر پیشرفتهای زیادی به خود دیده و در زمینهی خلق تصاویر واقعگرایانه بسیار دقیق عمل میکند.

دکتر سوفی نایتینگل، استاد روانشناسی در دانشگاه لنکستر بریتانیا، میگوید احتمال اینکه مردم بتوانند غیرواقعیبودن چهرهی خلقشده با هوش مصنوعی را تشخیص دهند تنها ۵۰ درصد است. به گفتهی او بسیاری از مردم در نگاه اول عقیده پیدا میکنند که چهرههای مبتنیبر هوش مصنوعی قابلاطمینانتر از چهرههای واقعی به نظر میآیند.

دکتر نایتینگل میگوید تمام افرادی که بدون دانش تخصصی دربارهی فتوشاپ یا CGI به ابزارهای تولید محتوای جعلی دسترسی داشته باشند، میتوانند از فناوری سوءاستفاده کنند. این استاد روانشناسی ادعا میکند که استفاده از الگوریتمهای دیپ فیک با اهداف منفی، درمقایسهبا فناوریهای قبلی تهدید بزرگتری محسوب میشود.

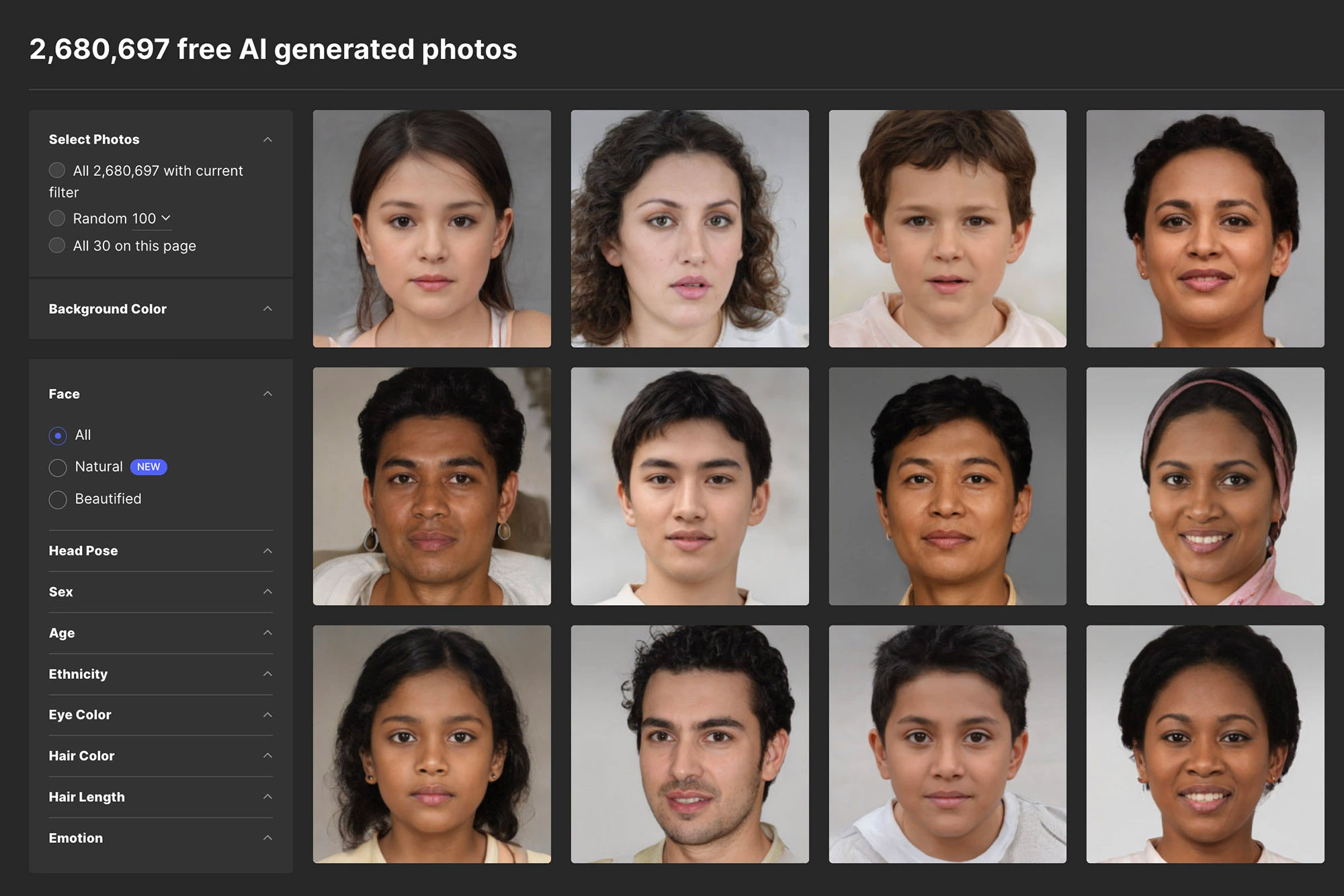

تصاویری از دیتاست FFHQ و تصاویر خلقشدهی StyleGAN2 که به سختی از هم قابلتشخیص هستند

یاسینه مکداد، پژوهشگر ایتالیایی امنیت سایبری در دانشگاه فلوریدای آمریکا که توانسته مدلی با دقت ۹۵٫۲ درصد برای تشخیص چهرههای جعلی طراحی کند، میگوید آنچه باعث واقعی شدن تصاویر خلقشده با هوش مصنوعی میشود ابزار استفادشده برای تولید آنها است.

به گفتهی مکداد شبکههای مولد تخصامی یا به بیانی بهتر، شبکههای زایای دشمنگونه (GAN) که از آنها برای خلق این تصاویر استفاده میشود از دو شبکهی عصبی مخالف بهره میگیرد که با هدف بهبود کیفیت نهایی تصویر، ضد یکدیگر کار میکنند. یکی از این شبکهها (G یا مولد) وظیفه دارد تصاویر جعلی را تولید کند و شبکهی دیگر را فریب دهد. دومین شبکه (D یا فرقگذار) یاد میگیرد که نتایج حاصل از شبکهی G را شناسایی و آنها را از چهرههای واقعی جدا کند. یاسینه مکداد میگوید «این بازی برآیند صفر» بین شبکهی G و شبکهی D به ابزار دیپ فیک امکان میدهد «تصویری غیرقابلتشخیص» تولید کند.

چهرههای خلقشده با هوش مصنوعی با سرعتی سرسامآور اینترنت را تصرف کردهاند. حساب توییتری لوبا دوژنکو برای خلق تصویر نهایی، تصویر دهها آدم واقعی را با هم ترکیب کرد. الگوریتمهای دیپ فیک اخیراً در پویشهای نگرانکنندهتری نیز استفاده شدهاند و این موضوع زنگ خطر را به صدا درمیآورد.

مقالههای مرتبط:

گوگل در سال ۲۰۲۰ یک پژوهشگر حوزهی اخلاقیات هوش مصنوعی به نام تیمنیت گبرو را اخراج کرد، چون گبرو مقالهای منتشر کرده بود که سوگیریهای موجود در الگوریتمهای گوگل را نمایش میداد. زمان کوتاهی پس از اخراج تیمنیت گبرو از گوگل، چندین حساب کاربری توییتری که در تصویر پروفایل آنها از چهرهی خلقشده با هوش مصنوعی استفاده شده بود بهیکباره ظاهر شدند و شروع به تخریب گبرو کردند. این حسابهای کاربری مدعی شدند که عضو سابق تیم تحقیقات هوش مصنوعی گوگل هستند و به تمامی کاربرانی که از گبرو حمایت کرده بودند نیز حمله کردند. اقدامات مشابه توسط کشورهایی مثل چین نیز انجام شده است تا روایتهای دولتی در شبکههای اجتماعی ترویج داده شود.

اگر توییتر را بهصورت گذرا بررسی کنید، قطعاً زیاد طول نمیکشد تا با حسابهایی که از چهرهی جعلی استفاده میکنند مواجه شوید. گردانندگان بسیاری از حسابهایی که دربارهی موضوعات جنجالی مثل واکسن توییت مینویسند، در پشت چهرههای خلقشده با هوش مصنوعی پنهان میشوند.

توییتر و فیسبوک بهشدت با این حسابهای اسپم مخالفند و در صورت شناسایی، آنها را سریعاً از دسترس خارج میکنند. حتی توییتر ادعا کرده که روزانه بیش از یک میلیون حساب کاربری اسپم مسدود میکند. این شبکههای اجتماعی چارچوبی برای مقابله با ترولهایی که از چهرهی جعلی استفاده میکنند ندارند، حتی با وجود اینکه توییتر مشخصاً در بخش رهنمودهای کاربران اعلام کرده «جعل هویت افراد، سازمانها یا گروهها با هدف فریب دیگران یا استفاده از هویت جعلی بهگونهای که روی تجربهی کاربری افراد دیگر تأثیر منفی بگذارد» ممنوع است.

یک شرکت حوزهی هوش مصنوعی به نام Sensity تخمین میزند که بین ۰٫۲ تا ۰٫۷ کاربران شبکههای اجتماعی معروف از تصاویری که با کامپیوتر خلقشدهاند استفاده میکنند. این عدد در نگاه اول چندان بزرگ به نظر نمیرسد، اما فراموش نکنید فیسبوک، اینستاگرام و توییتر بهترتیب دارای ۲٫۹ میلیارد، ۱٫۴ میلیارد و ۳۰۰ میلیون کاربر هستند و حتی بخش کوچکی از آنها معادل میلیونها حساب کاربری است. این حسابها میتوانند در پویشهایی که اطلاعات نادرست را رواج میدهند شرکت کنند.

تولیدکنندهی یک افزونهی مرورگر گوگل کروم که توانایی تشخیص چهرههای جعلی را دارد، ادعاهای شرکت Sensity را تأیید کرده است. آلبرتو ریتزولی، مدیرعامل V7 Labs میگوید بهطور میانگین یک درصد از تصاویری که مردم در فضای آنلاین آپلود میکنند، جعلیاند.

بازارگاه چهرههای جعلی

یکی از عواملی که به تکثیر بیش از حد چهرههای جعلی در شبکههای اجتماعی کمک کرده این است که بهراحتی میتوان به چنین چهرههایی دسترسی پیدا کرد. در پلتفرمهایی مثل Generated Photos همهی افراد میتوانند با پرداخت تنها چند دلار به صدها هزار چهرهی غیرواقعی با کیفیت بالا دسترسی پیدا کنند. از طرفی افرادی که به چند تصویر جعلی برای اهدافی کوتاهمدت مثل پویشهای هتک آبروی افراد نیاز دارند و نمیخواهند پول خرج کنند میتوانند سراغ وبسایتهایی مثل thispersondoesnotexist.com بروند. هر بار که این وبسایت را بارگذاری کنید، تصویر جعلی کاملاً جدیدی ایجاد میشوند.

وبسایتهای این چنینی باعث شدهاند زندگی برای افرادی مثل بنجامین استریک بسیار چالشبرانگیزتر باشد. استریک مدیر تحقیقات مرکز انعطافپذیری اطلاعات در بریتانیا است و اعضای تیمش روزانه چندین ساعت از زمان خود را صرف رهگیری و تجزیهوتحلیل محتوای فریبنده در فضای آنلاین میکنند.

بنجامین استریک میگوید: «اگر فناوریهای مولد خودکار را وارد مجموعهای از پروفایلهای دارای چهرهی جعلی کنید و خودتان را بهعنوان عضو استارتاپی جعلی جا بزنید، میتوانید در فضای آنلاین مهندسی اجتماعی انجام دهید و سراغ رفتارهای بسیار فریبنده بروید.»

ایوان براون، بنیانگذار پلتفرم Generated Photos میگوید که نباید با نگاه تماماً منفی به این قضیه نگاه کنیم. او ادعا میکند که تصاویر خلقشده با GAN موارد استفادهی بسیار مثبتی نیز دارند؛ نظیر ناشناس کردن چهرهها در سرپیس استریت ویو گوگل مپس و شبیهسازی دنیای مجازی در بازیهای ویدیویی. او میگوید پلتفرم تحت مدیریتش استفاده از تصاویر جعلی را برای این اهداف ترویج میدهد.

براون میگوید که امیدوار است سیستمهای دفاعی ویژهی Generated Photos بتوانند جلوی افراد سودجو را بگیرند و فعالیتهای آسیبزا را شناسایی کنند. براون پیشبینی میکند که شبکههای اجتماعی در نهایت بتوانند عکسهای خلقشده با هوش مصنوعی را از عکسهای واقعی تشخیص دهند.

البته تنظیم مقررات برای فناوریهای مولد مبتنیبر هوش مصنوعی کار دشواری است. چون این فناوریها پایهگذار تعداد زیادی از خدمات ارزشمند هستند. یکی از کاربردهای چنین فناوریهایی فیلتر جدید اسنپچت و زوم است که نورپردازی صحنه را بهصورت هوشمند تنظیم میکند.

جورجیو پاترینی، مدیرعامل Sensity، میگوید مسدودسازی سرویسهایی مثل Generated Photos نمیتواند جلوی گسترش چهرههای خلقشده با هوش مصنوعی را بگیرد. او معتقد است که پلتفرمهای مختلف باید رویکردهای جدیدی برای مقابله با این نوع تصاویر اتخاذ کنند.

مدیر تحقیقات شرکت Graphika (فعال در حوزهی تجزیهوتحلیل شبکههای اجتماعی) میگوید تا زمان مقابلهی سرسختانه و جدی پلتفرمها، استفاده از محتواهای جعلی باعث کاهش اعتماد مردم به نهادهای دولتی و رسانهها میشود. او میگوید برای مبارزه با سوءاستفادههای این چنینی از فناوری باید سیستمهایی آموزشی آغازبهکار کنند و به مردم یاد دهند که چگونه معتبر بودن منابع خبری را بررسی کنند.

چگونه جعلی بودن چهرهها را در فضای آنلاین تشخیص دهیم؟

خوشبختانه راههایی مطمئن برای تشخیص چهرههای خلقشده با هوش مصنوعی وجود دارد. نکتهی مهمی که نباید فراموش کنید این است که تصاویر این چنینی بهسادگی با ترکیب هزاران عکس ایجاد شدهاند. بنابراین با اینکه تصویر نهایی واقعگرایانه بهنظر میرسد، در صورتی که دقت کنید میتوانید متوجه نکاتی عجیب در تصویر شوید.

ممکن است فرم گوشها یا حتی گوشوارهها با یکدیگر همخوانی نداشته باشند، یا احتمال دارد تارهای مو در همهجای تصویر حضور داشته باشند. همچنین ممکن است قاب عینک عجیب به نظر برسد. با دقت به موارد دیگر نیز میتوانید نکتههایی غیرطبیعی در تصاویر پیدا کنید.

برجستهترین نشانه این است که در اکثر تصاویر خلقشده با هوش مصنوعی چشمهای فرد در موقعیت ثابتی قرار میگیرند: مرکز صفحهنمایش. ویدیوی زیر را ببینید تا به این موضوع پی ببرید.

در تصاویر خلقشده با هوش مصنوعی، معمولاً موقعیت چشمهای فرد ثابت است و در مرکز تصویر دیده میشود

دکتر سوفی نایتینگل میگوید بزرگترین تهدید ناشی از تصاویر خلقشده با هوش مصنوعی، دامن زدن به محتواهای دروغین است. هرچه تعداد محتواهای مربوط به موضوعی خاص بیشتر باشد، احتمال اینکه مردم آن موضوع را جعلی تلقی کنند کاهش پیدا میکند.

دکتر نایتینگل میگوید: «اگر نتوانیم دربارهی حقایق اساسی دنیای اطرافمان خردورزی کنیم، جوامع و دموکراسیهای ما درمعرض خطری جدی قرار میگیرند.»