در آینده، شبکههای اجتماعی به معتبرترین منابع تبدیل میشوند

مدتی پیش مدیرهای عامل توییتر و فیسبوک در مقابل کنگره قرار گرفتند تا از آنها دربارهی مسائل مختلفی که در شبکههای اجتماعی آنها در جریان است سؤال شود. آنها در بعضی از موارد حتی زیر سؤال رفتند و به موارد مختلفی متهم شدند. به این کار اصطلاحا Techlash گفته میشود. این واژه از دو کلمه Backlash و Technology تشکیل شده است که به ترتیب، «واکنش شدید» و «فناوری» معنا میشوند . این اصطلاح به واکنش شدید علیه شرکتهای بزرگ فناوری اشاره دارد؛ کاری که اکنون در واشنگتن بهوفور انجام میشود.

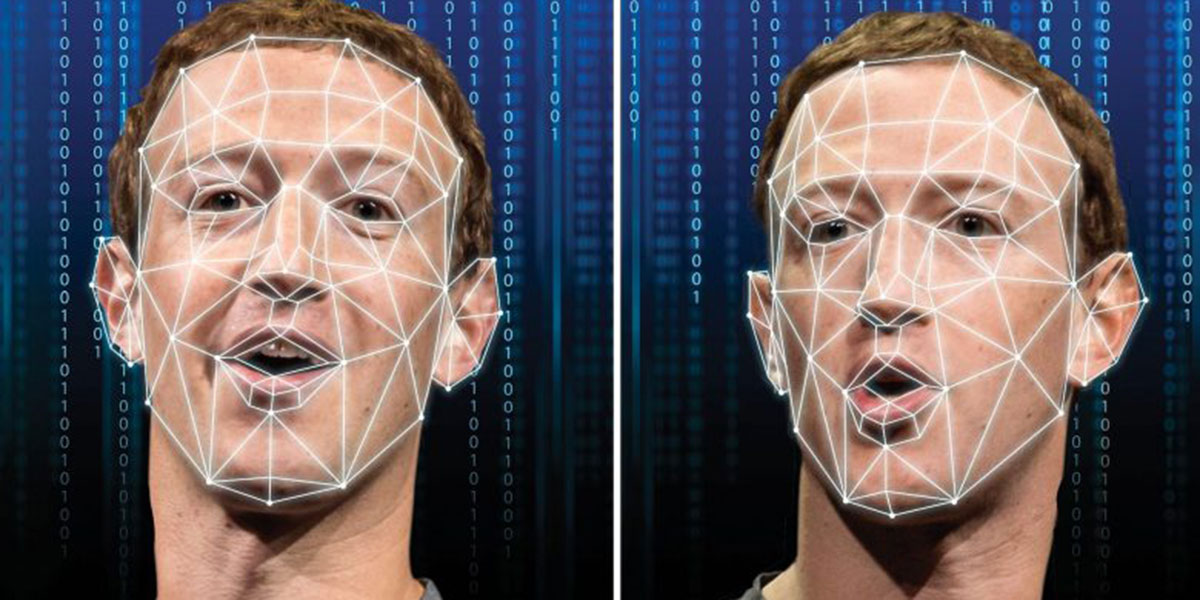

اعضای کمیته قضایی سنا نگران تعصبات سیاسی، اعتیاد، اشاعهی نفرت و مهمتر از همه، بحران اطلاعات غیر مجاز هستند. شبکههای اجتماعی جایی هستند که افراد معمولی، نظریهپردازان توطئه و تبلیغات داخلی بهراحتی با مشخصات کاربری تقلبی، الگوریتمهای اجتماعی را برای پخش اخبار جعلی دور میزنند. یک سال پیش، بسیاری انتظار داشتند که با استفاده از یک فیلم کاملا جعلی، رسوایی سیاسی بدی در انتخابات اخیر ایالات متحده آمریکا ایجاد شود. این اتفاق نیفتاد و یکی از دلایل این است که فیلمهای تقلبی ساختهشده توسط فناوری دیپ فیک هنوز توسط چشم انسان قابل تشخیص هستند.

اما از طرفی دیگر، تصاویر تقلبی ساختهشده با فناوری مشابه به قدری تکامل پیدا کردهاند که مردم نمیتوانند بین عکس یک شخص واقعی و یک عکس جعلی تفاوت قائل شوند. و این همان اتفاقی بود که در انتخابات اخیر آمریکا افتاد.

نمونههایی از محتوای جعلی منتشرشده در فضای مجازی

یک ماه پیش از آغاز مراحل اصلی انتخابات ریاست جمهوری ایالات متحده آمریکا، پروندهی عجیبی از اعمال ناشایست اخلاقی برای هانتر بایدن (پسر جو بایدن) در فضای مجازی منتشر شد. اما پس از مدت کوتاهی یک تحلیلگر امنیتی سوئیسی به نام مارتین آسپن، اعلام کرد که اطلاعات منتشرشده جعلی هستند. شرکتی که این ادعا را کرده بود تقلبی از آب درآمد و تحلیلهای انجامشده نیز صحت نداشتند. حتی تصویر پروفایل نیز توسط فناوری دیپ فیک ایجاد شده بود.

درواقع این حرکت یک ضربه سیاسی تقویتشده با هوش مصنوعی بود که بسیاری انتظار داشتند با یک ویديوی جعلی دیپ فیک همراه باشد؛ اما بخش اعظم اطلاعات نادرست منتشرشده دربارهی هانتر بایدن یک متن بود که با یک تصویر جعلی همراهی میشد. قرار بود این جملات زمانی که در کنار یک تصویر دستکاریشده قرار میگیرند، قانونی جلوه کنند. از قضا، یک نقص در عکس وجود داشت که باعث شد روزنامهنگاران با دقت بیشتری به کل پرونده نگاه کنند.

در یک اتفاق جداگانه، اخیرا یک کمپین اطلاعاتی طرفدار چین به نام «Spamouflage Dragon» توسط شرکت تحقیقاتی Graphika کشف شد. در این کمپین کاربران جعلی همراه با تصاویر پروفایل تقلبی در توییتر و یوتیوب به دنبال تأثیرگذاری بر افکار عمومی بودند. این کاربران جعلی با انتشار ویدئوهای جعلی سعی در تغییر عقیده مردم درباره ممنوعیتهای اعمالشده روی تیک تاک داشتند.

دیپ فیک، فناوری جعل محتوای قابل دسترسی

بخشی از مشکل اینجا است که ساخت ویدئوهای جعلی با فناوری دیپ فیک کار سختی نیست و کاربران زیادی به کلیپهای ساختهشده دسترسی خواهند داشت. این بدان معنا است که هم ساخت این فایلهای تقلبی آسان است و هم انتشار ویروسی آنها کار سختی به نظر نمیرسد. اکنون حتی کاربران میتوانند با استفاده از یک اپلیکیشن، ظرف مدت چند ثانیه یک ویدئوی دیپ فیک درست کنند.

اخیرا یک ربات ساخت دیپ فیک در برنامه پیامرسان تلگرام توسط شرکت اطلاعات تهدید بصری Sensity کشف شده است. این شرکت ادعا میکند که ربات مذکور درواقع مسئول «اکوسیستم دیپ فیک» است و تاکنون بیش از ۱۰۰ هزار تصویر جعلی ایجاد کرده. این نشان میدهد که برای ساختن این گونه آثار تقلبی، حتی در بعضی موارد به نصب برنامهی خاصی نیاز نیست. این مسئله اصلا خوب نیست؛ شاید بسیاری برای سرگرمی این تصاویر و ویدئوها را ایجاد کنند اما همیشه هستند کسانی که فکرهای دیگری در سر پرورش میدهند.

اکنون یک نوع مسابقهی عجیب در یوتیوب در حال انجام است؛ یوتیوبرهای مختلف برای ساخت بهترین دیپ فیک چهرهی سلبریتیها با یکدیگر رقابت میکنند. در هر نسخهای که منتشر میشود، چهرهها شبیهتر از قبل میشوند و این مسئله با وجود جذاب بودن میتواند خطرناک باشد. این یعنی هر انسانی میتواند از خانهی خود این آثار جعلی را بسازد و منتشر کند. آخرین موارد به چهره جیم کری روی شخصیت جوکر خواکین فینیکس مربوط میشود.

سازندگان سریال انیمیشن South Park یک کانال کمدی در یوتیوب راهاندازی کردهاند که Sassy Justice نام دارد و در آن از فیلمهای جعلی دیپ فیک افراد مشهور بهویژه دونالد ترامپ برای محتوای طنز و هجو استفاده میکنند.

حتی دیده میشود که از فناوری دیپ فیک برای ساخت آهنگهای جعلی با سبک خود خواننده استفاده شده است؛ پیشتر از این بعضی از تولیدکنندگان محتوا، پارودی آهنگهای معروف را میساختند؛ اما آنها اکنون میتوانند از چهره و صدای اصلی خواننده استفاده کنند. در آیندهای نهچندان دور با استفاده از تکنیکهای جعل صدا، میتوان موسیقیهای جدیدی برای خوانندگان تولید کرد؛ بدون اینکه حتی صدا از گلوی آنها خارج شود.

در این مقاله، دربارهی مشکلات اجتماعی پیشآمده توسط فناوری دیپ فیک صحبت میکنیم؛ اما باید به این نکته اشاره کرد که محتوای تقلبی تولیدشده توسط هوش مصنوعی در حال تبدیل شدن به یک مشکل تجاری درحالرشد است.

استفاده از فناوری دیپ فیک در حملات مهندسی اجتماعی (Social engineering attacks) در حال حاضر کاملا ثابت شده است. اکنون میتوان با کمک دیپ فیک صوتی با فردی تماس گرفت و بدون اینکه او شک کند، جای شخص دیگری صحبت کرد. فرض کنید یکی از عزیزانتان به شما زنگ میزند و در خواست پول میکند. شما شک نمیکنید؛ چون او دقیقا مانند فردی صحبت میکند که میشناسید؛ در نتیجه احتمالا مبلغ مورد نظر را برای او واریز میکنید بدون اینکه حتی لحظهای به جعلی بودن این تماس فکر کنید.

تنها راه مقابله با دیپ فیک

تنها یک راه حل پیش روی ما وجود دارد؛ برای مقابله با این فناوری باید به فناوری قدرتمندتری دسترسی داشته باشیم. باید به جایی رسید که بتوان با استفاده از اپلیکیشنهای جدید بهسرعت ویدئوها، تصاویر و صوتهای دیپ فیک را تشخیص داد. محققان در دانشگاهها و شرکتهای فناوری سخت در تلاش هستند تا ابزار کشف آثار جعلی تولید کنند. البته تاکنون نمونههای جالبی ساخته شدهاند که میتوانند امیدوارکننده باشند.

مقالههای مرتبط:

برای مثال ابزار FakeCatcher دانشگاه بینگهمتون «اطلاعات جریان خون» را در صورت سوژههای فیلم کنترل میکند تا واقعی یا جعلی بودن آن را تشخیص دهد. دانشگاه میسوری و دانشگاه کارولینای شمالی در شارلوت در حال کار روی ابزاری هستند که میتواند در لحظه جعلی بودن تصویر و فیلم را تشخیص بدهد. تقریبا از همه جای جهان در حال کار بر این پروژه هستند؛ مؤسسه پیشرفته علوم و فناوری کره جنوبی ابزاری مبتنی بر هوش مصنوعی به نام Kaicatch برای شناسایی عکسهای تقلبی عمیق ایجاد کرده است. اما مهمتر از همه این است که شرکتهای فناوری در حال کار روی آن هستند؛ پس میتوان امید داشت که بهزودی تولید چنین ابزاری به مرحله نهایی میرسد.

مایکروسافت اخیرا ابزار جدیدی ارائه داده است که سعی در کشف تصاویر و فیلمهای دیپ فیک دارد؛ البته هنوز کامل نشده است. این ابزار از برچسب واقعی یا جعلی برای مشخص کردن محتوای درست استفاده نمیکند؛ بلکه گفته میشود اپلیکیشن Authenticator این شرکت نتیجه نهایی را با یک امتیاز مشخص میکند. هنوز بهطور کامل شیوهی کارکرد این ابزار مشخص نیست.

فیسبوک شبکه اجتماعی بود که با راه انداختن «چالش تشخیص دیپ فیک/ Deepfake Detection Challenge» سعی کرد محققان را به کشف راههای جدید و کارآمد برای این کار تشویق کند.

درواقع با هر پیشرفت در فرایند ایجاد آثار دیپ فیک، محققان تلاش میکنند قانعکننده بودن آن را کاهش دهند؛ البته این کار برای کامپیوترها انجام میشود؛ زیرا انسان ممکن است در هر صورت این ویدئوها، تصاویر و اصوات جعلی را باور کند.

امروزه فایلهای جعلی تولیدشده توسط هوش مصنوعی با شوخی، کمدی، اطلاعات نادرست سیاسی و هجو در شبکههای اجتماعی همراه است. ما اکنون در اواخر بازه زمانی هستیم که چشمان غیر مسلح میتوانند تصاویر جعلی را تشخیص دهند. در آینده، به معنای واقعی کلمه، هیچ راهی برای تشخیص تفاوت رسانههای جعلی با رسانههای واقعی وجود نخواهد داشت؛ پیشرفت در هوش مصنوعی از این امر اطمینان حاصل خواهد کرد. مطمئن باشید در آیندهای نزدیک فقط هوش مصنوعی قادر به شناسایی محتوای تولیدشده توسط هوش مصنوعی خواهد بود.

بنابراین مسئله این است؛ هنگامی که فناوری تشخیص محتوای دیپ فیک تولید شود، چه زمانی و کجا از آن استفاده خواهد شد؟

تبدیل شدن شبکههای اجتماعی به معتبرترین منابع

اولین و بهترین مکان در خود شبکههای اجتماعی خواهد بود. شبکههای اجتماعی مشتاق استفاده، توسعه و تکامل چنین تکنیکی برای شناسایی لحظهای رسانههای جعلی هستند. در آینده احتمالا ابزار مذکور قادر به بررسی محتوا در لحظه خواهد بود.

این بدان معنا است که در آیندهای نزدیک، اطلاعاتی که در شبکههای اجتماعی مانند توییتر، اینستاگرام و فیسبوک مشاهده میکنید در قابل اطمینانترین حالت خود قرار خواهند گرفت؛ زیرا هوش مصنوعی روی همه موارد بارگذاریشده اعمال میشود. البته مسلما سایر پستها لزوماً به این فناوری برای تشخیص صحت اطلاعات نیازی نخواهند داشت.

اما این پایان ماجرا نیست؛ زیرا کلاهبرداران و مبلغلن مسائل کذب به دیگر رسانهها روی خواهند آورد. برای مثال منبع جعلی میتواند کاری کند روزنامهنگاران دچار اشتباه شوند و مطالب دروغ چاپ کنند. همچنین هنوز استفاده از تماسهای دیپ فیک یک تهدید جدی محسوب میشود که ممکن است خرابیهای بسیاری به بار بیاورد.

در آینده، احتمالا شبکههای اجتماعی به معتبرترین منابع تبدیل میشوند و شما هر آنچه در آنها میخوانید، باور میکنید. در آن زمان رسانههای دیگر از اعتبار کمتری برخوردار خواهند بود. آینده ممکن است همه چیز، حتی نوع نگاه شما به رسانهها مختلف را تغییر دهد.

نظر شما کاربران زومیت درباره این موضوع چیست؟